如何把控网站的抓取频率(提高数据爬取效率的技巧和策略)

![]() 游客

2024-06-19 12:27:01

72

游客

2024-06-19 12:27:01

72

随着数据挖掘和分析技术的迅速发展,越来越多的公司和个人开始使用网络爬虫来收集和分析各种数据。然而,一些不适当的爬虫操作可能会导致被抓取网站的服务质量下降,甚至被封禁。为了避免这种情况的发生,我们需要掌握一些技巧和策略来把控网站的抓取频率。

合理规划爬取任务

在开始爬取之前,我们需要合理规划爬取任务。要确定目标网站的数据结构和数据量,然后根据数据量大小、网站的服务质量等因素,合理安排爬取时间和频率。可以通过增加代理IP、使用分布式爬虫等方式来提高爬取效率。

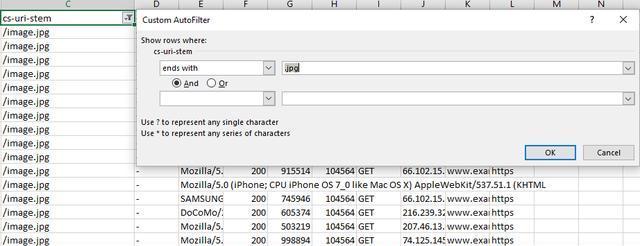

设置合理的请求头

在发起请求之前,我们需要设置合理的请求头。一些网站会通过判断请求头中的User-Agent、Referer等信息来识别是否为爬虫行为。我们可以通过设置随机化的请求头信息来避免被识别出爬虫行为。

使用robots.txt协议

robots.txt协议是一种用于限制网络爬虫访问网站的协议。在爬虫程序中,我们可以通过读取robots.txt文件中的限制规则来避免访问被限制的页面或文件,从而避免被封禁。

限制访问频率

为了避免对目标网站造成过大的压力,我们可以通过限制访问频率来降低爬虫行为对服务器的负载。具体做法可以是设置固定的请求间隔时间、根据服务器返回的状态码设置访问间隔时间等。

使用缓存机制

网络爬虫在访问同一网站时,可能会反复获取相同的数据。为了避免无效的重复访问,我们可以使用缓存机制来缓存已经获取过的数据,在下次访问时直接从缓存中读取数据。

避免并发访问

并发访问是指同时有多个爬虫程序访问同一网站。如果并发访问过多,会对网站造成较大负担,从而影响其他用户的服务质量。我们需要避免并发访问,可通过设置最大并发数、根据服务器响应速度自动调整并发数等方式进行控制。

注意反爬虫策略

为了保护自己的利益,一些网站会采用反爬虫策略来防止被不良行为侵害。在进行网络爬虫行为时,我们需要注意不要触犯反爬虫策略,可通过模拟真实用户行为、模拟浏览器行为等方式来规避反爬虫策略。

及时维护和更新爬虫程序

网络环境和网站服务质量都是不稳定的,因此我们需要及时维护和更新爬虫程序。如果出现异常情况或者网站服务发生变化时,需要及时调整和更新程序代码以保证正常运行。

合理规划任务、设置合理请求头、使用robots.txt协议、限制访问频率、使用缓存机制、避免并发访问、注意反爬虫策略、及时维护和更新程序代码,这些技巧和策略都可以帮助我们把控网站的抓取频率,提高数据爬取效率。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自火狐seo,本文标题:《如何把控网站的抓取频率(提高数据爬取效率的技巧和策略)》

标签:

- 搜索

- 最新文章

- 热门文章

-

- 快手屏蔽关键词的开启方法是什么?

- 企业网站建设制作需要注意什么?企业网站建设制作的流程是什么?

- 设计网站如何进行优化?常见问题有哪些?

- 抖音如何设置关键词搜索到我?设置方法是什么?

- 免费的视频素材网站有哪些?如何利用这些资源制作视频?

- 百度关键词SEO优化技巧有哪些?如何进行百度关键词优化?

- 长尾关键词是什么?如何选择合适的长尾关键词?

- 网站制作过程中需要注意哪些SEO优化?

- 搜索引擎SEO优化平台有哪些?平台的常见问题是什么?

- 设计企业网站有哪些要点?

- 高端网站制作的标准是什么?

- 网站设计与制作需要注意哪些问题?如何保证网站的设计感?

- 抖音不提示关键词了吗怎么回事?如何解决关键词不提示的问题?

- 抖音关键词包年运营的步骤是什么?

- 关键词优化seo怎么做?有哪些有效的方法?

- 网站制作的流程是怎样的?如何建立一个成功的网站?

- 网站制作建立需要多长时间?如何加快制作进度?

- 抖音直播中风水相关的违禁关键词有哪些?

- 制作企业网站的流程是怎样的?如何选择企业网站建设公司?

- 百度seo优化的策略是什么?如何实施?

- 热门tag

- 标签列表

- 友情链接