搜索引擎的定义及发展历史

![]() 游客

2024-09-18 15:54:01

59

游客

2024-09-18 15:54:01

59

在当今信息时代,搜索引擎已成为人们获取信息的重要途径之一。然而,大家对于搜索引擎的原理和工作机制却不是很了解。本文将详细解析搜索引擎的原理,帮助读者更好地理解搜索引擎的工作过程和搜索结果。

搜索引擎的定义及发展历史

搜索引擎是一种能够根据关键词快速检索出网络信息的工具,其发展历史可以追溯到上世纪90年代初期。当时,人们开始意识到互联网的信息量巨大且迅速增长,需要一种快速准确地检索网络信息的方法。

搜索引擎的工作原理

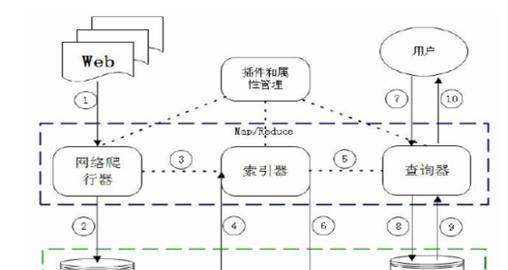

搜索引擎的工作原理主要包括爬取、索引和查询三个过程。爬虫程序会自动抓取互联网上的网页,并将这些网页存储在搜索引擎的数据库中。接着,搜索引擎会对这些网页进行分析和分类,并将其编入索引中。当用户输入关键词进行查询时,搜索引擎会根据索引中的相关度和排序算法,将与关键词相关的网页展现给用户。

搜索引擎的爬取过程

搜索引擎的爬取过程主要由爬虫程序完成。爬虫程序会从一个起始点开始,通过分析网页中的链接,并不断地跳转到其他网页,以此来获取更多的信息。在爬取过程中,爬虫程序还会对网页内容进行处理和分析,并将其存储到搜索引擎的数据库中。

搜索引擎的索引过程

搜索引擎的索引过程主要由索引程序完成。索引程序会对爬取到的网页进行分析和分类,并将其编入到索引中。索引程序还会对网页中的关键词进行提取和分析,并根据关键词的重要性进行排名。通过索引程序的处理,搜索引擎可以建立一套包含众多网页和关键词的信息库。

搜索引擎的查询过程

搜索引擎的查询过程主要由查询程序完成。当用户输入关键词进行查询时,查询程序会通过与索引库进行匹配,找出与关键词相关的网页。查询程序还会根据相关度和排序算法对这些网页进行排序,并将排名靠前的网页呈现给用户。同时,查询程序还会根据用户行为和反馈对搜索结果进行优化和调整。

搜索引擎的相关度算法

搜索引擎的相关度算法主要用于确定搜索结果的相关程度。常见的相关度算法包括TF-IDF算法、PageRank算法、链接分析算法等。TF-IDF算法是一种基于关键词频率和出现位置的算法,PageRank算法是一种基于网页链接关系的算法,链接分析算法则是将PageRank算法与文本分析结合起来的一种算法。

搜索引擎的排序算法

搜索引擎的排序算法主要用于对搜索结果进行排名。常见的排序算法包括BM25算法、随机游走算法、机器学习算法等。BM25算法是一种基于文本相似度的算法,随机游走算法是一种基于网络链接关系的算法,机器学习算法则是将用户行为和反馈等数据应用于排序中的一种算法。

搜索引擎的反作弊机制

为了保证搜索结果的质量和可靠性,搜索引擎通常会采取一些反作弊机制。常见的反作弊机制包括关键词密度控制、链接质量评估、内容重复度检测等。这些机制旨在防止网站采用一些不正当手段来提高网站排名,从而影响搜索结果的准确性和公正性。

搜索引擎的局限性和改进方向

虽然搜索引擎已经成为人们获取信息的重要工具,但其仍存在一些局限性。搜索结果可能会受到广告推广的影响,有些内容也可能会被搜索引擎过滤掉。为了解决这些问题,搜索引擎需要不断进行改进和优化,以提高搜索结果的准确性和可靠性。

搜索引擎的分类和应用

根据搜索引擎的特点和功能,其可以分为通用搜索引擎和垂直搜索引擎两种类型。通用搜索引擎可以检索出各种类型的信息,如Google、百度等;而垂直搜索引擎则针对某一领域或行业进行搜索,如知乎、课程猴等。同时,搜索引擎也广泛应用于各种领域,如电商、旅游、教育等。

搜索引擎与SEO

SEO是指通过对网站结构、内容、链接等因素的优化,来提高网站在搜索引擎中的排名和曝光度。SEO既可以提高网站流量和用户量,也可以降低网站的营销成本。SEO已成为互联网营销中不可或缺的一部分。

搜索引擎的未来发展趋势

随着信息技术的不断发展,搜索引擎也在不断更新和演化。未来,搜索引擎将会更加注重用户体验和个性化服务,通过人工智能、大数据等技术来提高搜索结果的准确性和智能化程度。

搜索引擎的安全性问题

随着网络安全风险的不断加剧,搜索引擎的安全性问题也逐渐引起了人们的关注。搜索引擎需要加强对恶意软件、黑客攻击等安全威胁的防范,提高用户数据的保护和隐私权利的保障。

搜索引擎的社会影响

搜索引擎作为一种重要的信息工具,已经深刻地影响着人们的生活和工作。然而,搜索引擎也存在一些负面影响,如信息过载、谣言传播等问题。我们需要更加理性地使用搜索引擎,减少其对我们生活和工作的干扰。

搜索引擎作为信息时代的重要工具,其原理和工作机制也需要我们了解和掌握。通过本文的介绍,我们可以更好地理解搜索引擎的工作过程和原理,以及其对人们生活和工作的影响和作用。同时,我们也需要更加理性地使用搜索引擎,才能发挥出其最大的效益。

深入剖析搜索引擎的工作原理

随着互联网的发展,搜索引擎成为了我们获取信息的最主要途径之一。但是,我们对搜索引擎工作原理的了解却非常有限。本文将深入探讨搜索引擎背后的技术,带您全面了解搜索引擎是如何实现快速、精准的检索服务的。

1.爬虫是什么?

爬虫是搜索引擎检索网页信息的基础,它会以一定的规则遍历网页,并将网页上的内容保存下来。爬虫需要根据一定的算法决定要抓取哪些网页。

2.爬虫的工作流程是什么?

爬虫的工作流程分为链接爬取、页面下载、页面解析和存储四个步骤。爬虫会根据预设规则查找新的链接,然后访问这些链接并下载网页内容。接着,爬虫会将下载的页面进行解析,并从中提取出所需信息。爬虫将处理后的数据保存到搜索引擎的数据库中。

3.如何保证爬虫的效率?

为了提高爬虫的效率,搜索引擎通常会采用多台机器进行分布式爬虫,并设置爬取深度和时间间隔等策略来限制爬虫的规模和频率。

4.索引是什么?

索引是搜索引擎用来存储网页信息的数据库,通常使用倒排索引的方式实现。倒排索引是指将网页中的每个词语作为索引关键字,然后将这些关键字与网页URL进行映射,方便用户通过关键字查找相关网页。

5.倒排索引的实现原理是什么?

倒排索引采用了哈希表或者红黑树等数据结构,将每个词语作为关键字,建立一个词语到对应网页URL的映射。用户在搜索时,只需根据关键字查找对应的网页URL即可。

6.如何优化索引的查询效率?

为了提高索引的查询效率,搜索引擎通常会使用内存索引、压缩索引、分布式索引等技术。内存索引是将索引数据保存在内存中,加快查询速度;压缩索引则是通过压缩算法减小索引数据的存储空间;分布式索引则是将索引数据存储在多台机器上,实现高并发查询。

7.排名是什么?

排名是搜索引擎根据关键字查询结果的权威度排序。排名可以通过用户点击率、网页质量等多个因素计算得出。

8.如何计算排名?

搜索引擎通常会使用PageRank算法、TF-IDF算法等方式计算排名。PageRank算法是一种根据网页间链接关系来计算网页权重的算法,而TF-IDF则是根据网页内容的词频和文档频率计算网页权重的算法。

9.如何优化排名?

为了优化排名,网站需要针对搜索引擎算法进行SEO优化。这包括优化网站结构、增加关键词密度、提升页面质量等方式。

10.搜索引擎如何保证数据的准确性和完整性?

搜索引擎通常会对网页信息进行去重、过滤和质量评估,保证数据的准确性和完整性。同时,搜索引擎还会对恶意网站进行屏蔽和封禁,以保证用户的安全。

11.搜索引擎如何实现个性化推荐?

为了实现个性化推荐,搜索引擎会根据用户历史搜索记录、兴趣偏好等信息,为用户推荐相关的内容。这可以通过用户登录或者Cookie等方式实现。

12.搜索引擎存在哪些安全风险?

搜索引擎存在被黑客攻击、恶意网站注入等安全风险。搜索引擎需要通过漏洞修复、安全检测等手段来保障用户安全。

13.未来搜索引擎的发展趋势是什么?

未来搜索引擎的发展趋势包括语义搜索、人工智能技术、移动搜索等方向。这将有助于提高搜索引擎的检索质量和用户体验。

14.搜索引擎的应用场景有哪些?

搜索引擎广泛应用于各种领域,包括学术研究、商业服务、公共服务等。搜索引擎的发展已经成为推动信息化建设的重要力量。

15.

搜索引擎是一项复杂的技术,其背后涉及爬虫、索引、排名等多个方面。只有深入了解搜索引擎工作原理,才能更好地利用搜索引擎获取所需信息。同时,随着搜索引擎技术的不断发展,我们也将迎来更加智能、个性化的搜索体验。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自火狐seo,本文标题:《搜索引擎的定义及发展历史》

标签:搜索引擎

- 搜索

- 最新文章

- 热门文章

-

- 如何开通百度LOGO权限?步骤和要求是什么?

- 企业网站设计服务中如何进行品牌定位?

- 抖音关键词搜索推广效果如何评估?

- 抖音关键词排名怎么看?

- 做企业网站设计需要考虑哪些因素?如何设计出符合企业需求的网站?

- 企业网站seo怎么做?如何提高网站的搜索引擎排名?

- 网站建设类服务包括哪些内容?如何选择网站建设类服务?

- 百度网站关键词优化有哪些技巧?如何快速提升?

- seo排名优化系统是什么?如何使用seo排名优化系统?

- 湖南网站建设哪家公司好?如何选择专业的网站建设服务商?

- 美团推广标准版关键词获取途径?

- 淘宝热词关键词查询用什么软件?如何快速找到热卖商品?

- 网站建设seo发展前景如何?未来趋势和机遇在哪里?

- 百度营销新用户怎么上传关键词

- 百度关键词推广工具是什么软件

- 个人做网站需要什么技能?有哪些免费资源可以利用?

- 企业网站设计应该注意哪些要点?如何体现专业性?

- 网站建设服务包括哪些内容?如何选择网站建设服务商?

- 抖音关键词的指数叫什么?如何查看关键词指数?

- 小红书关键词浏览量限制方法是什么?

- 热门tag

- 标签列表

- 友情链接